20 сентября 2023 г.

Как показало исследование Gartner, 34% организаций уже используют либо внедряют инструменты безопасности применения генеративного ИИ (GenAI), чтобы снизить связанные с ним риски, а более половины (56%) изучают такие решения.

Опрос был проведен с 1 по 7 апреля среди 150 руководителей ИТ и информационной безопасности в организациях, использующих GenAI или фундаментальные модели, планирующих их использовать или изучающих такую возможность.

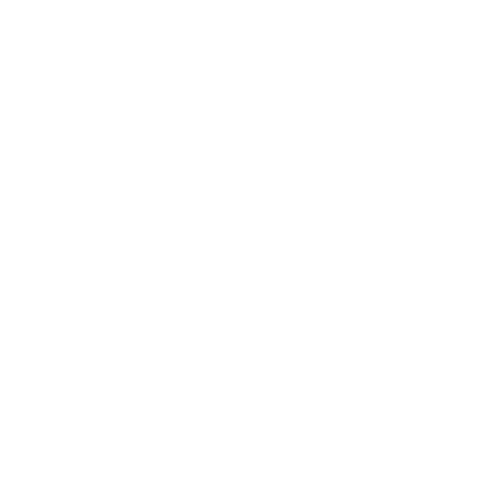

В ходе опроса 26% респондентов сообщили, что в настоящее время внедряют или используют технологии повышения конфиденциальности (PET), 25% используют ModelOps (управление жизненным циклом моделей), и 24% — мониторинг моделей (см. рис. 1).

Рис. 1. Организации, использующие или планирующие использовать инструменты, снижающие риски, связанные с генеративным ИИ (процент ответов)

(легенда):

- синий = Уже используем

- голубой = Внедряем

- черный = Изучаем

- серый = Не планируем внедрять

- светло-серый = Затруднились с ответом

(сверху вниз):

- Объясняемость моделей

- Мониторинг моделей

- Технологии повышения конфиденциальности (PET)

- ModelOps

- Безопасность использования ИИ

База: 150 респондентов

Примечание: Сумма цифр может отличаться от 100% ввиду округления.

«Руководители ИТ и управления безопасностью и рисками должны, помимо внедрения инструментов ИБ, продумать введение общекорпоративной стратегии TRiSM (управления доверием, рисками и безопасностью) для ИИ, — пишет в пресс-релизе Авива Литан (Avivah Litan), ведущий вице-президент-аналитик Gartner. — Она обеспечивает управление потоками данных и процессов между пользователями и компаниями, предоставляющими фундаментальные модели генеративного ИИ, и должна быть постоянно действующей, а не разовой мерой, чтобы обеспечить непрерывную защиту организации».

За безопасность GenAI обычно отвечает ИТ-отдел

В ходе проведенного опроса 93% руководителей ИТ и информационной безопасности сообщили, что хотя бы в некоторой степени участвуют в мерах управления безопасностью и/или рисками использования генеративного ИИ в своей организации, но лишь 24% ответили, что это является их прямой обязанностью.

Среди тех, кто не имеет такой обязанности, 44% сообщили, что главная ответственность за безопасность генеративного ИИ лежит на ИТ-отделе, а у 20% респондентов эта ответственность возложена на отдел управления рисками и комплаенс-контроля.

Главные риски

Риски, связанные с использованием генеративного ИИ, значительны, присутствуют постоянно и будут непрерывно меняться. Респонденты сообщили, что главными рисками для них являются нежелательные данные в выдаче и небезопасность кода, при этом 57% опасаются утечки секретов в коде, сгенерированном ИИ, а 58% — выдачи неверных или необъективных результатов («предвзятость» ИИ).

«Организации, не управляющие рисками ИИ, увидят, что их модели не работают как задумано, а в худшем случае могут нанести ущерб людям или имуществу, — пишет Литан. — Это будет приводить к нарушениям безопасности, финансовым и репутационным потерям и вреду людям из-за неточной, подстроенной, неэтичной или предвзятой информации в выдаче. Кроме того, некорректность работы ИИ может вести к принятию ошибочных бизнес-решений в организации».

Источник: Пресс-служба компании Gartner