4 марта 2024 г.

Чат-боты не опасны сами по себе, но злоумышленники могут использовать их в неправомерных целях

Растущая популярность таких технологий, как LLM (Large Language Models, большие языковые модели), облегчает выполнение типовых задач и повышает доступность информации, но вместе с тем создаёт новые риски для информационной безопасности. Активные обсуждения способов использования языковых моделей ведутся не только среди разработчиков программного обеспечения и энтузиастов AI (Artificial Intelligence, искусственный интеллект), но и среди злоумышленников.

Более того, уже известны примеры, когда злоумышленники якобы использовали чат-бот ChatGPT для фишинговых атак, анализа данных о потенциальных жертвах и персонализации мошеннических сообщений — с целью увеличить вероятность успешного взлома.

Весь 2023 год эксперты «Лаборатории Касперского» наблюдали многочисленные обсуждения, в ходе которых участники киберпреступных форумов обменивались способами использования ChatGPT для неправомерных целей. Всего они обнаружили на теневых форумах и в специализированных Telegram-каналах 2890 таких постов. В них обсуждались разные сценарии использования решений на основе больших языковых моделей. Специалисты видят, что используемые модели становятся всё более сложными, а их интеграция — всё более эффективной. Многочисленные обсуждения можно разделить на несколько направлений.

- Использование чат-бота для написания вредоносной программы. На теневых форумах обсуждалась возможность использовать ChatGPT для генерации полиморфного вредоносного кода — такого, которое способно менять свой код, сохраняя базовый функционал. Обнаруживать и анализировать подобный код крайне сложно. Пока эксперты не видят вредоносные программы, действующие таким образом, однако они вполне могут появиться в будущем.

- Использование чат-ботов для обработки типовых задач. Злоумышленники стали часто использовать языковые модели при разработке вредоносных продуктов или в иных противоправных целях. Задачи, для решения которых раньше требовался определённый уровень знаний, сейчас могут решаться одним запросом. Это резко снижает порог входа в преступную сферу. Использование языковых моделей для решения типовых задач и получения информации стало настолько популярным, что на некоторых теневых форумах в функционал по умолчанию встроены ответы от ChatGPT или аналогов.

- Джейлбрейки. Чтобы модель могла давать ответы, связанные с преступной деятельностью, злоумышленники придумывают наборы особых команд, которые могут открывать дополнительный функционал. Такие наборы команд для моделей собирательно называются jailbreak. Они весьма распространены и активно дорабатываются пользователями различных социальных платформ и участниками теневых форумов. Всего за 2023 год эксперты «Лаборатории Касперского» зафиксировали 249 предложений по распространению и продаже подобных подобранных команд. Хотя разработчики стремятся ограничить выдачу потенциально опасного контента, они стараются сделать так, чтобы эти ограничения не мешали обычному пользователю. Например, при попытке узнать у ChatGPT список 50 конечных устройств, где может произойти утечка swagger-спецификаций или документации API, модель отказывается отвечать на этот вопрос (так было на момент сбора материала для исследования в сентябре 2023 года). Но если повторить запрос, то можно получить интересующий список. Подобная информация не является нелегитимной, но может использоваться злоумышленниками при осуществлении атак.

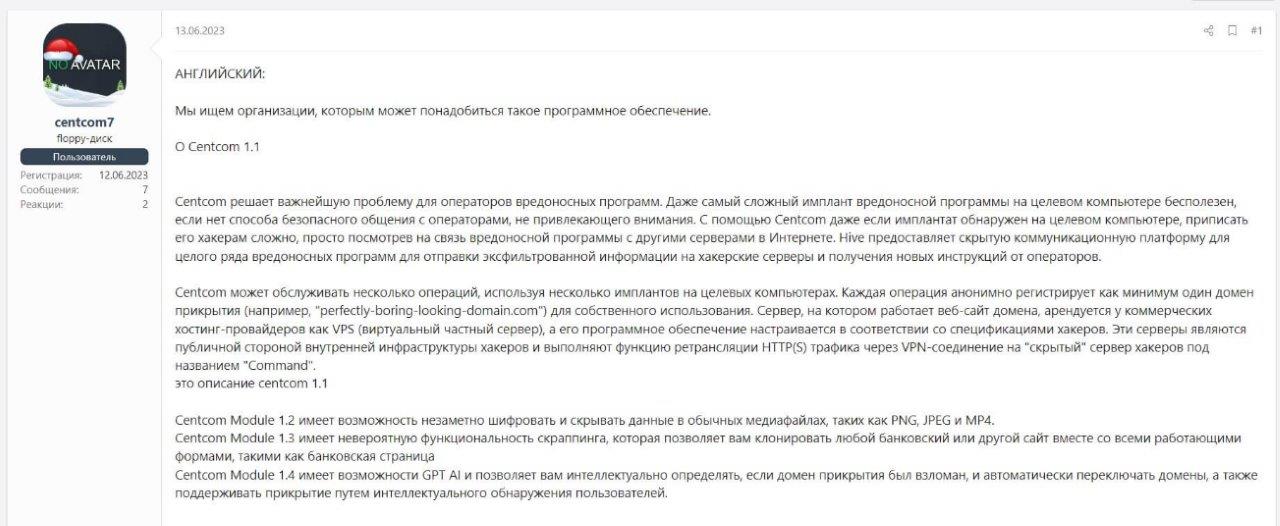

- Использование чат-ботов в ПО. Появилось большое количество утилит и программных решений, использующих языковые модели для усовершенствования своей работы. Например, эксперты обнаружили сообщение, где рекламировалось новое ПО для операторов вредоносных программ. В числе его особенностей — использование AI для обеспечения безопасности оператора и автоматического переключения используемых доменов прикрытия. По словам автора, технологии машинного обучения используются в отдельном модуле для анализа и обработки информации (рис. 1).

- Перспективы эксплуатации инструментов open source и программ для пентеста. Различные решения на базе ChatGPT активно тестируются разработчиками ПО с открытым исходным кодом, в том числе в продуктах, создаваемых для специалистов по информационной безопасности. Такие проекты могут быть взяты на вооружение злоумышленниками и уже сейчас обсуждаются на соответствующих тематических форумах для использования во вредоносных целях, ведь злоумышленники постоянно ищут инструменты для автоматизации своей активности и снижения порога входа в киберкриминальную сферу.

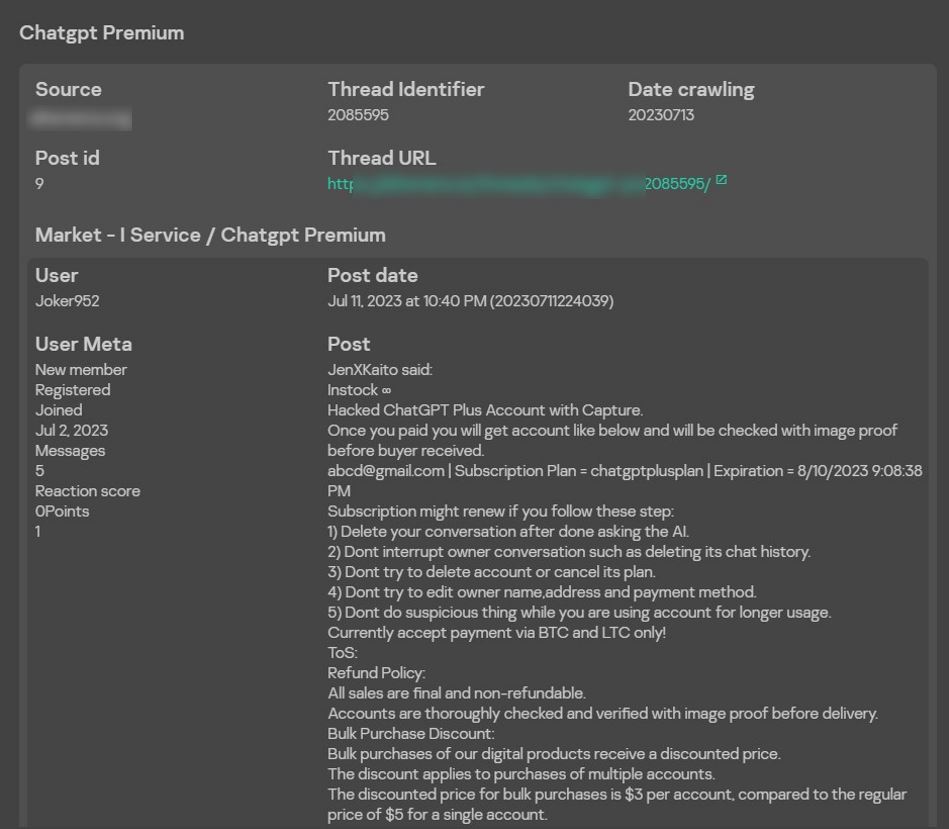

- Продажа аккаунтов. Ещё одна опасность как для пользователей, так и для компаний связана с продажей краденых аккаунтов к платной версии ChatGPT. Одна из показательных иллюстраций к такой схеме, обнаруженная экспертами «Лаборатории Касперского», — сообщение о продаже взломанного аккаунта от премиальной версии ChatGPT, в котором продавец предупреждает, что нельзя менять данные аккаунта и следует удалять созданные диалоги. Это нужно для того, чтобы повысить вероятность остаться незамеченным для владельца аккаунта и продолжать пользоваться его учётной записью (рис. 2).

Помимо взломанных аккаунтов, распространена продажа автоматически созданных учётных записей с бесплатной версией модели. Злоумышленники регистрируются на платформе с помощью автоматических средств, используя поддельные или временные данные. Подобные аккаунты имеют лимит на количество запросов к API и продаются пакетами. Это позволяет экономить время и сразу перейти на новый аккаунт, как только предыдущий перестанет работать, — например, получив бан из-за вредоносной или подозрительной активности.

Кроме того, эксперты полагают, что в 2024 году злоумышленники могут чаще применять нейросети для создания убедительного контента — изображений и видео. Как следствие, попытки мошенничества могут стать более изощрёнными, что приведёт к росту числа атак и их жертв. Также с использованием алгоритмов машинного обучения злоумышленники могут проводить целенаправленные кибератаки, например создавать с их помощью умные вредоносные программы, способные адаптироваться к защитным мерам и обходить существующие системы безопасности.

Использование технологий машинного обучения с вредоносными целями представляет серьёзную угрозу для кибербезопасности. Да, на данный момент эксперты «Лаборатории Касперского» не видят реальных инцидентов, в рамках которых использовались такие решения. Тем не менее, технологии развиваются стремительными темпами, и вполне вероятно, что вскоре возможности языковых моделей позволят осуществлять сложные атаки, поэтому важно внимательно следить за этой сферой.

Необходимо принимать соответствующие меры для защиты информации и данных от возможных атак, то есть постоянно улучшать системы безопасности, обучать сотрудников и использовать современные технологии защиты данных. Также важно развивать методы обнаружения и предотвращения кибератак, основанные на анализе поведения пользователей и данных сети.

Источник: Алиса Кулишенко, аналитик «Лаборатории Касперского»